Наверняка где-то в интернете есть уже написанные посты на эту тему. Но здесь хочется написать именно про свой прожитый опыт.

Я выделяю 2 золотых правила тестирования

1) убедись, что условия тестирования “чистые”. Что нет внешних факторов, которые могут повлиять на результаты тестирования

2) убедись, что у тебя достаточно данных по каждой выборке, чтобы принимать решение об окончании тестирования

Здесь я уж молчу про очевидную вещь “сделай так, чтобы сама ЦЕЛЬ тестирования была на 100% измеряемой”. Это уж точно должно быть по умолчанию. Если этого нет, то лучше и не беритесь за тестирование.

Для п.2 существует такой сервис – http://www.testsignificance.com – который позволяет рассчитать необходимое количество действий для каждой выборки, чтобы результаты тестирования можно было считать статистически значимыми

А вот здесь пойдёт детальная речь про п.1

Итак, нам дано:

1500 ключевых активных фраз с определенным текстом объявления

Задача:

Прописать новый тест объявления и пустить его в тестирование с текущим. Найти победителя, сравнивая общий средний CTR между этими текстами

Выполнение:

Казалось бы – тривиальная задача. Тем более в интерфейсе Яндекс.Директа уже есть функционал работы с группами. И Янедкс.Директ сам должен параллельно крутить то одно объявление, то другое, собирая по ним статистику

Этим путём я и пошёл. На каждую ключевую фразу было создано доп. объявление (чтобы сделать тестирование чистым и не создавать ключевую фразу заново, с нулевой статистикой). Т.е. создали 1500 новых текстов.

Тест шёл порядка 3х недель

Итоги:

Получили по 850 равных кликов для каждой выборки. Что же мы видим? Новые объявления как-то хуже работают. Аж на 2% по CTR. Может они действительно плохие? Может уже стоит принять решение и остановить тестирование?

Сразу скажу, чтобы добиться статистической значимости данных в 95%, нужно получить по 1400 кликов на каждую выборку. Пока ещё нет столько. Пока набрали лишь на 80%.

Т.е. с вероятностью в 80% !!!! можно говорить о том, что новые объявления работаю хуже.

А теперь, ВНИМАНИЕ, раскрывается изюминка данного поста:

Новые объявления = старые объявления!

Они одинаковы. Абсолютно. Буква в букву. Для каждой фразы теперь крутится поочередно 2 одинаковых объявления.

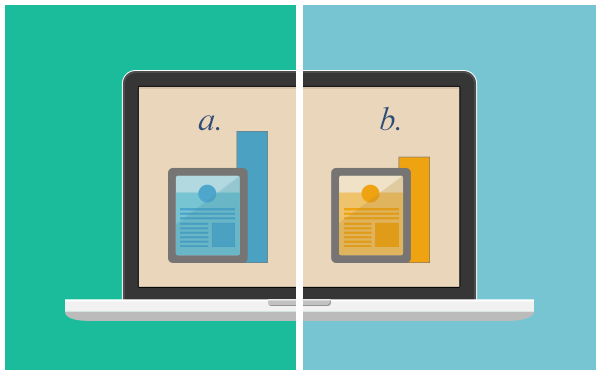

Это А-А тестирование!

Оно делается для того, чтобы замерить “чистоту эксперимента”. Чтобы понять, а нет ли во внешних условиях факторов, которые могут внести случайные коррективы в результаты тестирования? И если таких факторов нет, то можно делать уже А-Б тестирование

Согласитесь, что одинаковые объявления должны одинаково работать? Но почему же пока статистика говорит о другом?

Кто знает, кто знает….

Мне теперь интересно продолжить тестирование и получить по 1400 кликов на каждую выборку (чтобы получить статистическую значимость в 95%), чтобы увидеть, какие будут конечные результаты тестирования. И варианта будет 2

1) объявления всё же покажут одинаковые показатели. Тогда всё ок, внешняя среда чиста и пригодна для тестирования

2) объвяления НЕ покажут одинаковые показатели. Вот тут я серьёзно задумаюсь о целесообразности проведения вообще какого-либо тестирования в Яндекс.Директе. Ведь это означает, что в их алгоритмах есть ошибка…и результаты любого тестирования будут неверными

Увидим =) Отпишу пост об итогам, как соберу необходимые данные

А вы как считаете, почему получились такие показатели?

********* UPDATE от 06.02.15 ***********

Так вот…теперь данные набраны

По итогу были получены такие цифры

CTR новых заголовков ( = тех же самых) – 8.48%

Статистическая значимость – 90%

Все, хватить тестить! 2500 кликов на выборку – за глаза уже. И что же мы видим? Заголовки были одинаковые, а результаты разные. Можно, конечно, говорить, что они близки друг к другу..это да…

Но изначально речь шла о “чистом” эксперименте, где внешние факторы вроде как должны быть неизменными. И в таком случае показатели все же не должны отличаться на 1.3%. Это много.

А вот по заявкам все ровно – 50% с первого варианта текста, 50% – со второго. Хоть тут ровно )

Я после всего этого в очередной раз убедился в 3х моментах:

А) тестировать нужно “с умом”, понимая, как именно будут измерены и доказаны результаты теста

Б) Не хрен тестировать в Яндексе все подряд. Не все там так очевидно для тестирования. В данном случае где-то закрался внешний фактор, который все же вносил коррективы в показатели. Хоть Яндекс сам и говорит, что его алгоритмы для тестирования оч. круты.

В) А если и тестить, то лишь гипотезы, которые могут дать результаты, в РАЗы отличающиеся от текущих. А не слово в объявлении или ссылку на сайте….

Кстати, частенько, вижу, как “хвастаются” тем, что делают кучу а-б тестов объявлений, картинок и всего прочего. Ретаргетинг подключают сразу. И раньше на такое улыбался…и сейчас буду улыбаться. Думать надо, что делаете и зачем. А не делать ради того чтобы делать. Или чтобы продать. Ведь продать бОльший комплекс услуг (не факт, что нужных) можно задороже. Ведь так ? :=)

Это одно из действий, которые можно делать…а можно НЕ делать. А эффект будет один и тот же. Видимость действия….видимость работы

Т.ч. тестировать что-либо НАДО, но осторожно. Возможно, если бы тест длился лишь пару недель и на бОльшем объеме трафика, были бы лучше результаты. А т.к. это всё растянулось на 1.5 месяца + вносились изменения в кампании (но если и вносились, то так же дублировались данные в целях поддержания тестирования) + еще что-то…то это привело к тому, что тест не удался.

На этом всё. Удачной вам рекламы и результативных тестов!

—————

Если вам понравились наши статьи и вы хотите получать свежие посты на свой e-mail, то просто подпишитесь на нашу рассылку. В левой панели (где ссылки и vk-виджет) есть кнопка “Подписаться“. Кликайте на неё!